Le texte ci-dessous est accompagné des complément suivants :

- Un article de médiation scientifique intitulé « Moteurs, aéronautique, nucléaire… : la simulation numérique pour l'industrie » et publié dans le journal en ligne The Conversation (2017).

- Une vidéo d’une conférence de 45 mn intitulée « Le calcul scientifique pour les applications industrielles » (2017)

- Les planches de la conférence : Le calcul scientifique pour les applications industrielles (sans les animations)

La simulation numérique pour les applications industrielles

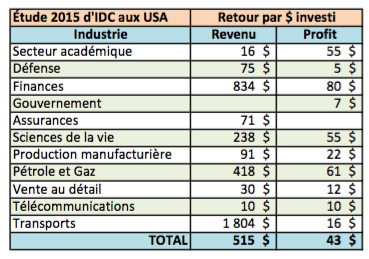

Une étude américaine ([1]) concernant une centaine d'organismes affirme qu'un dollar investi dans le Calcul à Haute Performance (HPC pour High Performance Computing en anglais) peut en rapporter 40 ! Le vrai chiffre se situe sans doute en-dessous de 10 si l'on prend on compte des entreprises diverses allant de grands groupes « High Tech » à des secteurs industriels plus anciens. Au-delà de ces statistiques, les conseillers et les décideurs du monde industriel souhaitent appréhender de manière concrète comment le recours à la simulation numérique peut améliorer la rentabilité et la compétitivité de leur entreprise. Nous donnons ici quelques exemples issus de collaborations entre le Cerfacs et ses partenaires industriels.

Table 1 : Retour sur investissement du HPC mesuré sur un échantillon d'une centaine d'entreprises nord-américaines. Étude 2015 par IDC ([1]).

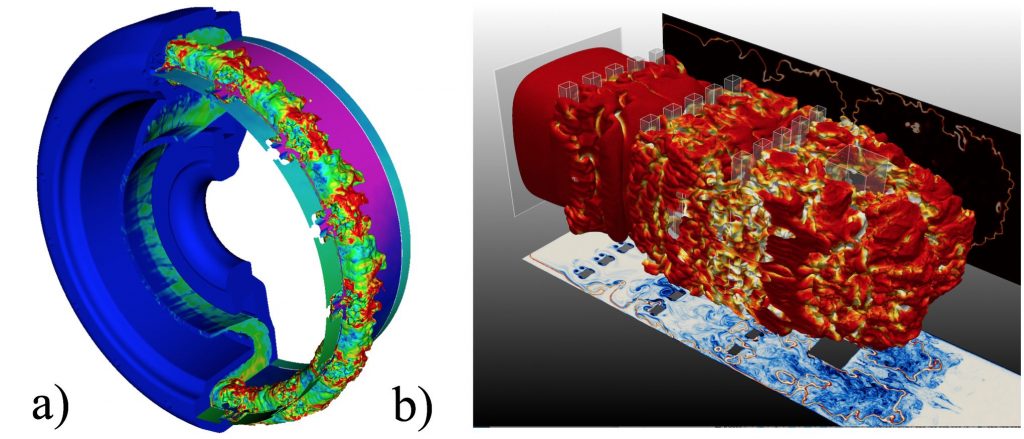

Conception des moteurs

La conception et la fabrication de moteurs (p. ex. automobiles ou hélicoptères), de réacteurs (p. ex. avions ou fusées) ou de turbines (p. ex. centrales thermiques ou nucléaires) est un secteur très compétitif. La fabrication de prototypes coûte cher, d'autant plus que l'on peut aboutir à leur destruction lors des essais. La frontière entre un moteur à haut rendement et un moteur défectueux tient parfois à peu de choses sur le plan de la conception. La combustion, qui combine des écoulements fluides et des réactions chimiques, est un phénomène très capricieux, sources d'instabilités potentielles que l'on doit à tout prix éviter. Les progrès de la simulation numérique, rendus possibles par la puissance des ordinateurs et les efforts de recherche en modélisation, permettent de remplacer la plupart des essais en laboratoire par des essais virtuels. Seul le prototype final, optimisé en tenant compte d'un grand nombre de contraintes, fait l'objet de validations grandeurs nature dans le monde réel. Les ingrédients nécessaires à ce type de modélisation sont multiples : mécanique des fluides turbulents, réactions chimiques, prise en compte d'échelles très différentes, diffusion de la chaleur, interactions fluide-structure, etc. La simulation numérique de la combustion est également développée au Cerfacs pour d'autres domaines comme par exemple l'étude des explosions et des déflagrations.

Figure 1 : Simulations numériques en combustion : a) allumage dans un turbine, b) propagation d'une explosion dans un bâtiment. ©Cerfacs.

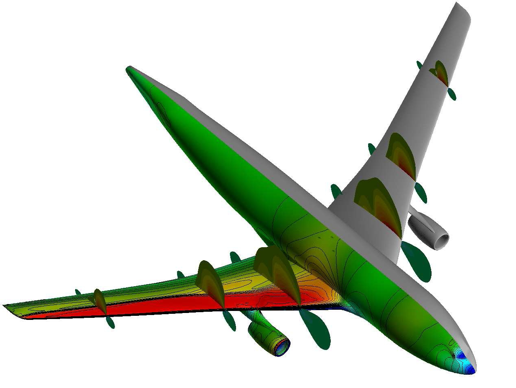

Conception aéronautique

Au-delà de l'aérodynamique interne modélisée pour les chambres de combustion, l'aérodynamique externe, par exemple autour d'un avion, met en œuvre des processus similaires : mécanique des fluides, turbulence au voisinage des parois, efforts exercés sur la structure et manœuvrabilité, sillage, etc. Alors que les codes de simulation numérique industriels se limitaient jusqu'ici à la description de l'écoulement moyen, l'usage de codes simulant la dynamique instationnaire des grandes structures tourbillonnaires est aujourd'hui possible et permet d'obtenir une description bien plus réaliste, nécessaire pour l'optimisation de l'aérodynamique des avions ou des automobiles. Grâce à ces outils, les ingénieurs vont pouvoir envisager des formes d'avions originales, adaptées à des cahiers des charges complexes comme la vitesse, la finesse, la trainée, le poids ou encore l'espace disponible. L'optimisation de forme permet, à l'aide de méthodes mathématiques avancées, de trouver des configurations idéales répondant à de nombreux critères. De nombreuses simulations numériques sont nécessaires lors de cette optimisation.

Figure 2 : Simulation numériques de la pression exercée sur un avion. ©Cerfacs.

Le suivi du cœur d'une centrale nucléaire

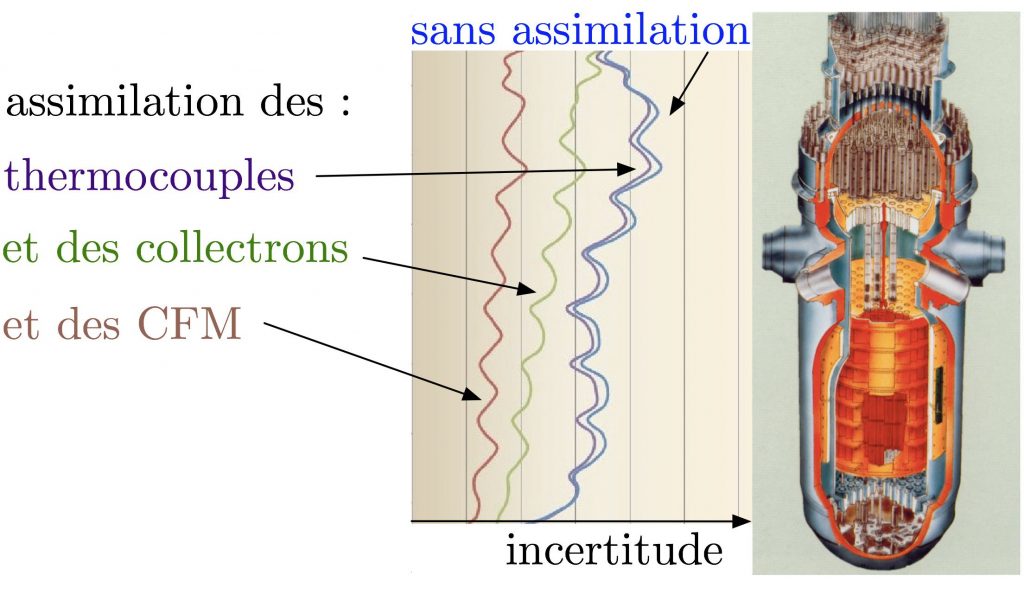

La simulation numérique permet de suivre en temps réel des systèmes complexes comme le cœur d'une centrale nucléaire. Il faut pour cela modéliser le flux neutronique émis lors de la réaction en chaine des atomes d'uranium de pastilles maintenues dans des crayons, de longues tiges métalliques disposées verticalement. Il faut également modéliser l'absorption des neutrons par le fluide caloporteur, de l'eau dans le cas du parc des réacteurs français, sa température ou encore sa concentration en constituants chimiques comme le Bore, utilisé pour modérer la réaction. Aussi bon que soit le modèle, ce qui est le cas pour cette application physique, un certain nombre d'incertitudes nécessitent d'alimenter régulièrement la simulation numérique par des mesures de grandeurs physiques dans l'installation suivie. Il s'agit par exemple de mesures du flux neutronique ou de la température de l'eau en certains points situés à l'intérieur du cœur de la centrale. Ces mesures, qui ne couvrent pas tout l'espace, sont alors combinées aux champs physiques prédits par le modèle pour obtenir une description plus fidèle de la réalité. Ce mélange entre données et modèles est l'objet de l'assimilation de données, une théorie qui fait appel aux statistiques et aux algorithmes mathématiques d'optimisation. Le principe de cette théorie consiste à pondérer les différentes informations, observées ou modélisées, en tenant compte de leur fiabilité. C'est ainsi que l'on peut réaliser avec une erreur inférieure au pour cent le suivi des cœurs de centrales nucléaires du parc français.

Figure 3 : Réduction des incertitudes par assimilation de données des mesures de températures (thermocouples) et de flux neutroniques (collectrons et CFM). ©Cerfacs et EDF.

L'assimilation de données pour l'analyse et la prévision

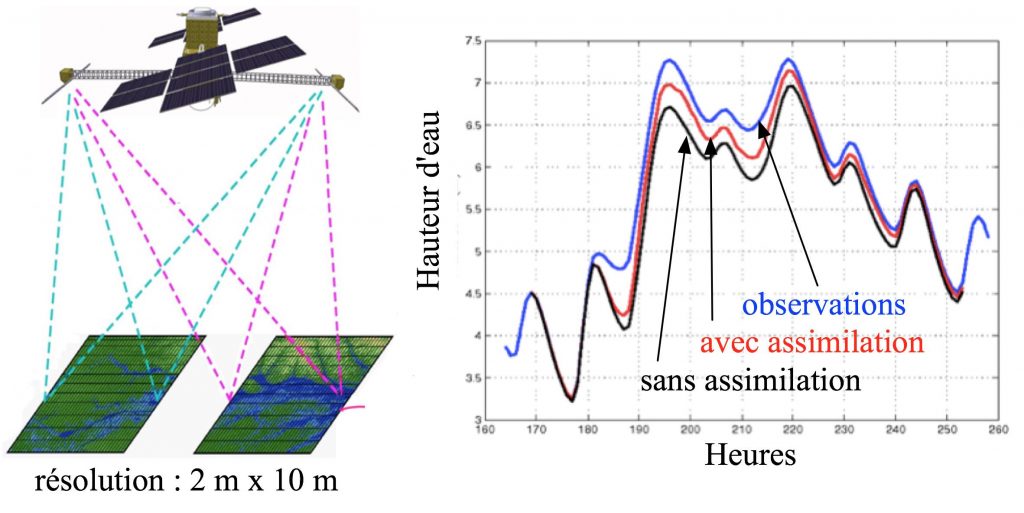

L'assimilation de données est une science qui s'est beaucoup développée dans le cadre de la prévision numérique du temps. Compte tenu de la grande sensibilité aux conditions initiales de la dynamique atmosphérique, les observations météorologiques sont indispensables pour corriger la dernière prévision du modèle. Il s'agit de représenter plusieurs champs tridimensionnels (la pression, la température, l'humidité et le vent) en des millions de points régulièrement répartis dans l'atmosphère, à partir de centaines de milliers d'observations irrégulièrement répartis en espace et en temps. Les calculateurs les plus puissants sont nécessaires pour simuler, à l'aide du modèle dynamique, plusieurs évolutions fictives de ces champs atmosphériques afin de déterminer celle qui se rapproche le plus des observations. L'assimilation de données est aujourd'hui présente dans tous les domaines de la physique suite à l'accroissement du nombre de mesures physiques et de la puissance des ordinateurs. En collaboration avec ses partenaires industriels, le Cerfacs participe aux efforts en recherche et développement sur plusieurs applications. La prévision des crues combine des modèles d'écoulements à surface libre de complexités diverses avec des observations de niveaux d'eau ou de débits mesurée in-situ ou par imagerie satellitaire. Une autre application relevant également de la prévention des risques concerne la modélisation des feux de forêts. La chimie atmosphérique constitue un autre domaine tirant partie des masses de données fournies par de nombreux satellites. La cartographie de constituants chimiques, comme par exemple l'ozone, fournit des renseignements précieux pour la prévision numérique du temps et bien d'autres applications. D'autres applications comme l'océanographie ou la modélisation des gisements de pétrole sont également des domaines étudiés au Cerfacs sous l'angle de l'assimilation de données.

Figure 4 : Mesures satellitaire s de la hauteur d'eau des rivières et prévision des crues avec assimilation de données. ©Cerfacs.

s de la hauteur d'eau des rivières et prévision des crues avec assimilation de données. ©Cerfacs.

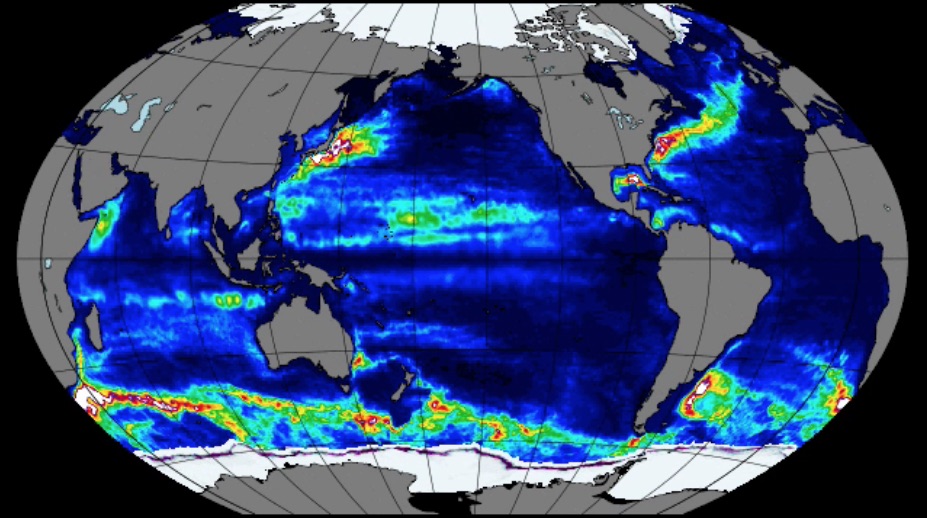

La quantification des incertitudes et les simulations d'ensemble

De même que l'assimilation de données est devenue un axe indispensable de la modélisation, la quantification des incertitudes doit aujourd'hui accompagner tout résultat issu d'une simulation numérique. Les deux domaines sont proches dans la mesure où l'assimilation de données pondère les données mesurées et modélisées en fonction de leur fiabilité et fournit, à l'issue du calcul, une estimation de la réduction des incertitudes obtenues en combinant toutes les informations. L'accroissement de la puissance des calculateurs permet d'envisager un grand nombre de simulations du même phénomène en perturbant de manière aléatoire les paramètres qui les gouvernent. Ces simulations d'ensemble, qualifiées d'expériences Monte-Carlo, permettent de quantifier les incertitudes d'un résultat en fonction des incertitudes des paramètres d'entrée. Même avec des ordinateurs très puissants, il convient toutefois de choisir convenablement les tirages aléatoires pour minimiser la taille des ensembles sans dégrader les conclusions. Des techniques mathématiques, comme par exemple la simplification du modèle à l'aide d'approximations (par ex. les polynômes du chaos), font l'objet de nombreuses recherches très rapidement appliquées à des cas concrets.

Figure 4 : Variabilité intrinsèque de la température de l'océan sur un demi-siècle, calculée à partir d'une simulation d'ensemble de 50 membres. ©Cerfacs.

Conclusion : de la simulation numérique à la science des données

Les quelques exemples d'applications de la simulation numérique présentés, à partir d'activités menées au Cerfacs, illustrent l'intérêt que représente la modélisation pour ses partenaires industriels. Une bonne représentation de la physique des phénomènes étudiés constitue la fondation de ces activités. Mais il n'est plus possible de s'en contenter pour être compétitif et la disponibilité d'un nombre croissant de mesures physiques nécessite une intrication de plus en plus étroite entre simulations numériques et données. L'assimilation de données permet de combiner mesures et modèles à l'aide de considération statistiques. Elle se nourrit et nourrit les analyses de quantification d'incertitudes qui reposent la plupart du temps sur des simulations d'ensemble. De plus en plus, la modélisation physique et le traitement des données se rejoignent dans une science parfois nommée HPDA (High Performance Data Analysis) ou encore « Big Data », même si ce terme désigne un domaine encore plus large.

Bibliographie

[1] E. Joseph, S. Conway, R. Sorensen, IDC HPC ROI Research Update: Economic Models For Financial ROI And Innovation From HPC Investments, 57th HPC User Forum, September 8-10 2015, Broomfield, Colorado

https://hpcuserforum.com/presentations/colorado-sept2015/PublicIDCDOEROIResearchUpdate8.19.2015.pdf